La transcription instantanée des contenus audio prend une nouvelle dimension sur iOS 26. Plus qu’un simple outil d’accessibilité, cette fonctionnalité s’intègre désormais directement au système pour offrir aux utilisateurs une expérience enrichie, qu’ils soient malentendants ou simplement soucieux de capter chaque mot d’un podcast ou d’une vidéo. Depuis que le français est pris en charge, toute conversion orale s’affiche en texte à l’écran, consolidant la promesse d’un accès élargi à l’information, quelles que soient les circonstances.

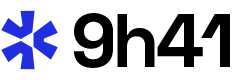

Découvrir les sous-titres en direct sur iOS 26

L’ajout des sous-titres en direct sur iOS 26 coïncide avec la volonté d’Apple de renforcer l’accessibilité dans son écosystème. Jusqu’alors réservée à l’anglais, cette option s’étend désormais au français, rendant la transcription automatique accessible à un public plus large. Une évolution attendue aussi bien par les personnes sourdes ou malentendantes que par ceux qui souhaitent lire un contenu lors d’un déplacement ou en milieu bruyant.

La technologie derrière ce service repose sur la reconnaissance automatique de la parole gérée localement par l’appareil. L’utilisateur n’a pas besoin de connexion internet active : tout se déroule sur le terminal grâce au moteur d’intelligence artificielle embarqué. Cette autonomie garantit la protection des données, limitant ainsi le transfert d’informations sensibles hors de l’iPhone ou de l’iPad.

Comment activer les sous-titres en direct sur iOS 26 ?

Activer les sous-titres en direct commence par un passage dans les réglages du système. Au sein du menu Accessibilité, une section dédiée aux « Sous-titres en direct » permet de configurer cette option à tout moment. Quelques ajustements suffisent alors à transformer le fonctionnement de l’appareil, rendant visibles, ligne après ligne, les paroles issues de podcasts, messages vocaux ou vidéos.

Une fois en place, les sous-titres surgissent automatiquement dès qu’un flux audio pertinent est détecté. Le panneau de transcription peut être déplacé sur l’écran selon les besoins : lecture discrète durant une réunion, supervision parentale pour enfants devant une vidéo éducative, ou tout simplement suivi précis lorsque l’environnement n’autorise pas l’écoute directe.

Personnaliser l’affichage et la langue

Pour adapter l’utilisation à ses préférences, divers réglages de personnalisation des sous-titres sont disponibles. Police, taille des caractères, contraste : l’idée consiste à garantir une lisibilité optimale. Depuis iOS 26, la prise en charge du français fluidifie toute transcription des dialogues entre interlocuteurs, quel que soit leur accent régional.

Changer la langue du système ou ajouter des variantes reste accessible via le même menu. Cela ouvre la porte à une utilisation plurilingue sans nécessiter d’intervention répétée, ce qui intéresse notamment étudiants et professionnels en contexte international.

Où visualiser la transcription en temps réel ?

La transcription en temps réel apparaît sous forme de fenêtre flottante, compatible avec tous les écrans du système. Un tapotement suffit à l’agrandir, la réduire ou la déplacer, selon l’application en cours. Depuis la version actuelle, il n’est plus nécessaire de passer par une application tierce pour obtenir ces fonctionnalités – l’intégration est native, ce qui réduit la latence et améliore la fiabilité du résultat affiché.

Dans certaines applications récentes, telles que Podcasts ou FaceTime, la fenêtre de sous-titres adopte parfois un style contextuel : incrustée au sein de la lecture vidéo ou placée dans une barre dédiée lors d’un appel pour ne rien manquer du dialogue échangé entre participants.

Les usages pratiques des sous-titres en direct

Au-delà de la seule accessibilité, de nouveaux comportements émergent autour de cette fonction. Transcrire intégralement un épisode de podcast facilite la prise de notes, tandis qu’écouter une émission en langues étrangères devient moins intimidant. Les créateurs de contenus audio voient ici un moyen supplémentaire de rendre leurs productions accessibles au plus grand nombre sans modifications techniques lourdes.

Dans la sphère privée comme professionnelle, l’avantage s’étend aux réunions à distance ou aux échanges téléphoniques : chacun garde une trace écrite du dialogue, pratique pour revenir sur une information importante sans devoir réécouter l’extrait original. L’apprentissage linguistique bénéficie aussi de cet outil, chaque phrase transcrite servant de support pour analyser vocabulaire, expressions idiomatiques ou tournures syntaxiques.

Différences entre iOS 26 et les versions précédentes

Sur iOS 18 ou les générations antérieures, les solutions dépendaient souvent d’applications externes avec niveaux variables de qualité. L’arrivée de cette transcription systématique a supprimé la nécessité de jongler entre interfaces, apportant cohérence et simplicité d’usage au quotidien. La rapidité de traitement et la compatibilité étendue constituent deux avancées soulignées par les utilisateurs.

Le modèle de gestion locale renforce également la sécurité, excluant le transit de voix via les serveurs extérieurs. À mesure que le moteur phonétique s’adapte, la fidélité de transcription progresse, répondant mieux aux subtilités grammaticales ou aux changements de rythme dans l’élocution.

L’expansion à d’autres appareils Apple

Avec iPadOS 26, Apple applique cette approche aux tablettes, offrant des adaptations similaires : nouveau design, personnalisation accrue, compatibilité renforcée avec divers contenus audiovisuels. Ordinateurs Mac et Apple Watch suivront possiblement, renforçant la cohérence d’ensemble chez les utilisateurs multisupports.

Le rôle joué par Apple Intelligence se manifeste progressivement dans des optimisations discrètes, du filtrage intelligent de bruit ambiant à la distinction automatique de locuteurs multiples lors de conversations de groupe ou d’interviews enregistrées.

Perspectives et évolutions à surveiller

La démocratisation des sous-titres en direct marque une impulsion forte du secteur tech vers l’inclusion, mais résulte aussi d’usages concrets relevés par tous types de profils. Rédiger une retranscription instantanée d’un message vocal reçu pendant un trajet, suivre un exposé en langue étrangère, consulter une conférence scientifique à distance sans casque audio : autant d’exemples où ce progrès technique trouve sa légitimité.

À mesure que la compréhension du langage naturel continue de progresser sur mobile, observer comment les plateformes articuleront expérience utilisateur, respect de la vie privée et performance soulève un nouvel intérêt, dépassant la simple accessibilité pour s’inscrire dans la routine numérique quotidienne.